Na Politechnice Krakowskiej trwają prace nad wykrywaczem deepfake’ów w treściach wideo, audio i obrazach. Rozprzestrzeniane m.in. w Internecie, zwłaszcza w mediach społecznościowych, fałszywe materiały tego typu stają się coraz bardziej niebezpieczne. Mogą być narzędziem cyberprzestępstw, a także politycznej walki i społecznych manipulacji. Naukowcy Politechniki Krakowskiej do walki z deepfake’ami chcą użyć ich … własnej broni – nowoczesnych technik opartych na sieciach neuronowych i metodach uczenia głębokiego. Prace nad projektem pt. „Detekcja zmanipulowanych treści audio-wideo w celu ochrony przed rozprzestrzenianiem wiadomości o charakterze deepfake” prowadzone są w ramach I konkursu „Infostrateg” Narodowego Centrum Badań i Rozwoju. Zespół z PK otrzymał na nie dofinansowanie w wysokości blisko 4 mln zł.

– Zakładamy, że te same lub pokrewne metody uczenia maszynowego, które są wykorzystywane do produkcji treści typu deepfake, mogą być użyte do detekcji zmanipulowanych treści – mówi kierownik projektu dr hab. inż. Michał Bereta, prof. PK z Wydziału Informatyki i Telekomunikacji Politechniki Krakowskiej. W finale prac jego zespołu powstanie automatyczny system do weryfikacji treści typu obraz/dźwięk/wideo, z którego będą mogli korzystać m.in. pracownicy mediów, redakcje, agencje PR i inne podmioty, chroniące wizerunek swoich klientów i produktów, portale internetowe i społecznościowe, policja i inne służby zapewniające bezpieczeństwo, także organizacje pozarządowe i wszyscy zainteresowani sprawdzaniem wiarygodności treści. – Stworzymy narzędzie, które będzie w stanie szybko ocenić, czy badany materiał – zdjęcie, materiał wideo, materiał audio – jest autentyczny, zmanipulowany, czy też całkowicie wykreowany za pomocą metod generatywnych. Wykrywacz może mieć formę prostego w obsłudze serwisu internetowego, który oceni dany materiał albo konkretny adres internetowy i wszystkie dostępne pod nim materiały graficzne, wideo i audio. Można też będzie stale monitorować dany adres internetowy albo – chroniąc konkretną osobę przed atakami typu deepfake – pojawiające się w sieci materiały z jej udziałem – mówi Michał Bereta.

– Zakładamy, że te same lub pokrewne metody uczenia maszynowego, które są wykorzystywane do produkcji treści typu deepfake, mogą być użyte do detekcji zmanipulowanych treści – mówi kierownik projektu dr hab. inż. Michał Bereta, prof. PK z Wydziału Informatyki i Telekomunikacji Politechniki Krakowskiej. W finale prac jego zespołu powstanie automatyczny system do weryfikacji treści typu obraz/dźwięk/wideo, z którego będą mogli korzystać m.in. pracownicy mediów, redakcje, agencje PR i inne podmioty, chroniące wizerunek swoich klientów i produktów, portale internetowe i społecznościowe, policja i inne służby zapewniające bezpieczeństwo, także organizacje pozarządowe i wszyscy zainteresowani sprawdzaniem wiarygodności treści. – Stworzymy narzędzie, które będzie w stanie szybko ocenić, czy badany materiał – zdjęcie, materiał wideo, materiał audio – jest autentyczny, zmanipulowany, czy też całkowicie wykreowany za pomocą metod generatywnych. Wykrywacz może mieć formę prostego w obsłudze serwisu internetowego, który oceni dany materiał albo konkretny adres internetowy i wszystkie dostępne pod nim materiały graficzne, wideo i audio. Można też będzie stale monitorować dany adres internetowy albo – chroniąc konkretną osobę przed atakami typu deepfake – pojawiające się w sieci materiały z jej udziałem – mówi Michał Bereta.Deepfake – co to jest?

Zjawisko deepfake jest stosunkowo nowe – datowane na rok 2017, gdy użytkownik internetowego forum Reddit o nazwie „deepfakes” zapoczątkował niechlubny trend udostępniania filmów pornograficznych, w których zamiast twarzy aktorek umieszczano twarze znanych celebrytek. Do osiągnięcia tego efektu użyte zostały nowoczesne techniki oparte na sieciach neuronowych i metodach uczenia głębokiego. Już wcześniej, po zaproponowaniu w roku 2014 sieci GAN (Generative Adversarial Networks), czyli modeli będących w stanie generować nowe obrazy, pojawiły się niesamowite możliwości zastosowań sieci neuronowych w wirtualnych manipulacjach treściami. Sztandarowym przykładem była możliwość preparowania zdjęć ludzi, którzy nigdy nie istnieli (łatwy dostęp do serwisu z takimi zdjęciami, ułatwia np. tworzenie fałszywych kont w serwisach społecznościowych).

Obecnie najczęściej jako deepfake rozumie się jakąkolwiek nieprawdziwą informację, która rozprzestrzenia się wirusowo zazwyczaj poprzez media społecznościowe bądź kanały medialne niezbyt dbające o weryfikację źródeł dystrybuowanych przez siebie informacji. W bardziej wąskim i specjalistycznym znaczeniu, termin ten opisuje zawartość medialną, zazwyczaj video lub audio, która wygenerowana została z wykorzystaniem metod obliczeniowych sztucznej inteligencji (SI), nowoczesnych metod uczenia głębokiego. Nazwa deepfake wzięła się z połączenia „deep learning” (ang. głębokie uczenie) oraz „fake”(fałszywy).

„Fałszywką” w demokrację

– W ostatnich latach użycie nowoczesnych metod obliczeniowych SI lawinowo się rozpowszechniło, również na obszary związane ze sceną i życiem politycznym. To sprawia, że problematyka deepfake została zauważona szerzej – zarówno w mediach, jak i w świadomości decydentów politycznych oraz różnego rodzaju organizacji dbających o porządek społeczny. Dostrzegać zaczęto wiele zagrożeń, nie tylko możliwość osobistego zniesławienia, jak w przypadku zmanipulowanych filmów pornograficznych, ale również możliwość wykorzystania tego typu materiałów do nieczystej gry politycznej, a nawet zakłócania procesu wyborczego w krajach demokratycznych – mówi prof. Bereta.

Naukowe zainteresowanie wypracowaniem metod rozpoznawania deepfake’ów pojawiło się wcześniej, zaraz za technikami wytwarzania takich materiałów audio/wideo. Za tym idzie z kolei zainteresowanie rynku komercyjnymi rozwiązaniami do detekcji deepfake’ów. W skali światowej pojawiają się pierwsze próby oferowania usług weryfikacji treści, ale – m.in. ze względów bezpieczeństwa pracujące nad nimi firmy – nie upubliczniają szczegółów implementacyjnych swoich modeli detekcyjnych. – Produkty tego typu jak wykrywacz, nad którym pracujemy w Krakowie, pozostają często w zasobach państw, w których powstają – podkreśla ekspert Politechniki. – W naszym rozwiązaniu zaproponujemy unikatowe techniki obliczeniowe, na rynku polskim nie są znane jeszcze rozwiązania odpowiadające naszemu funkcjonalnością i dostępnością.

Naukowa broń do detekcji

W narzędziu do detekcji deepfaków naukowcy z PK zamierzają zastosować nie tylko sieci neuronowe, lecz również opracować specjalne lokalne deskryptory, optymalizację rozwiązań z wykorzystaniem ewolucyjnych algorytmów optymalizacyjnych oraz rozwiązania hybrydowe. – Elastyczna implementacja modeli detekcyjnych pozwoli na ich zintegrowanie z zewnętrznymi rozwiązaniami za pomocą specjalnego API. Rozwiązanie nie będzie miało charakteru zamkniętego. Nawet po zakończeniu prac nad projektem modele detekcyjne będą mogły być dostosowywane do nowych rodzajów materiałów deepfake poprzez analizowanie nowych danych trenujących – zapowiada prof. Michał Bereta.

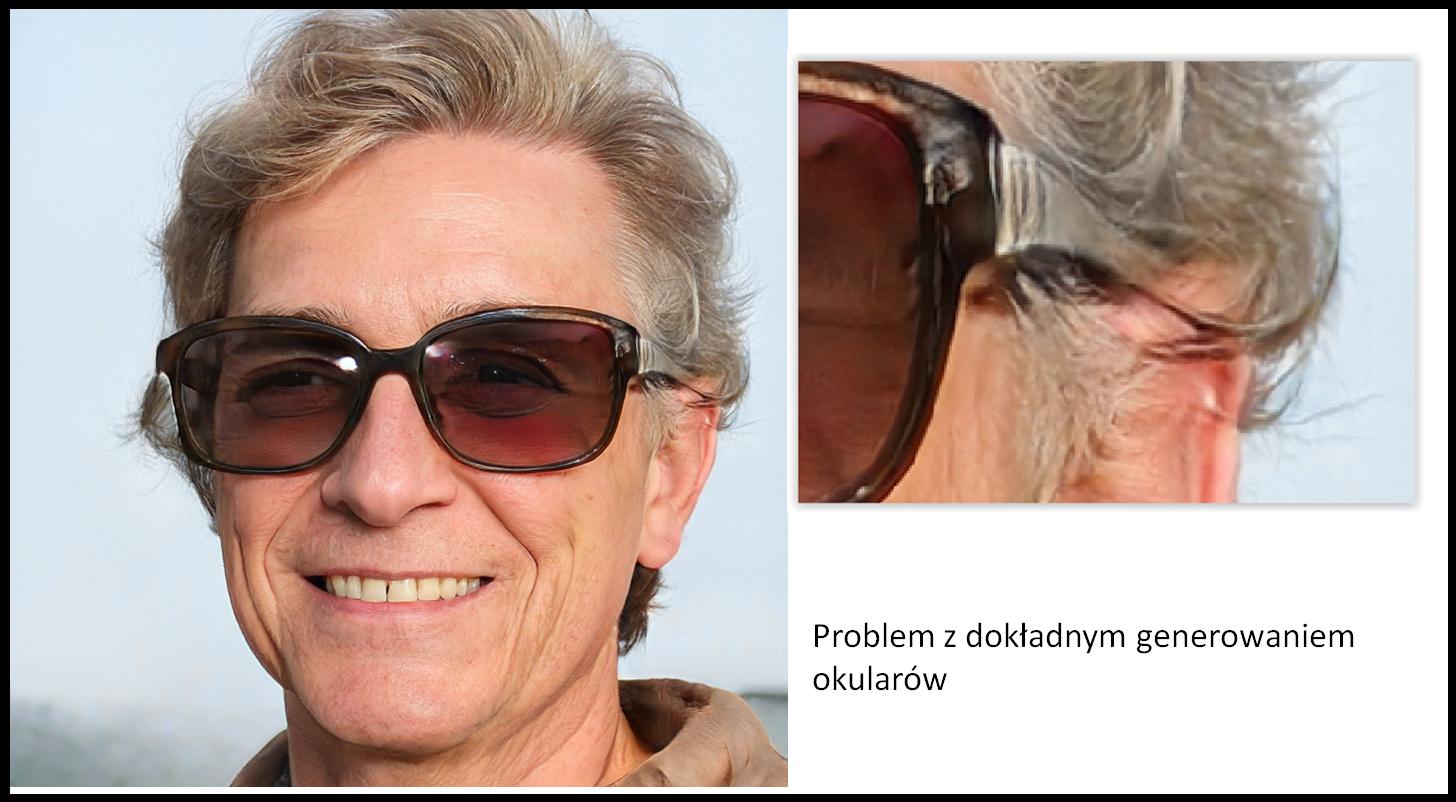

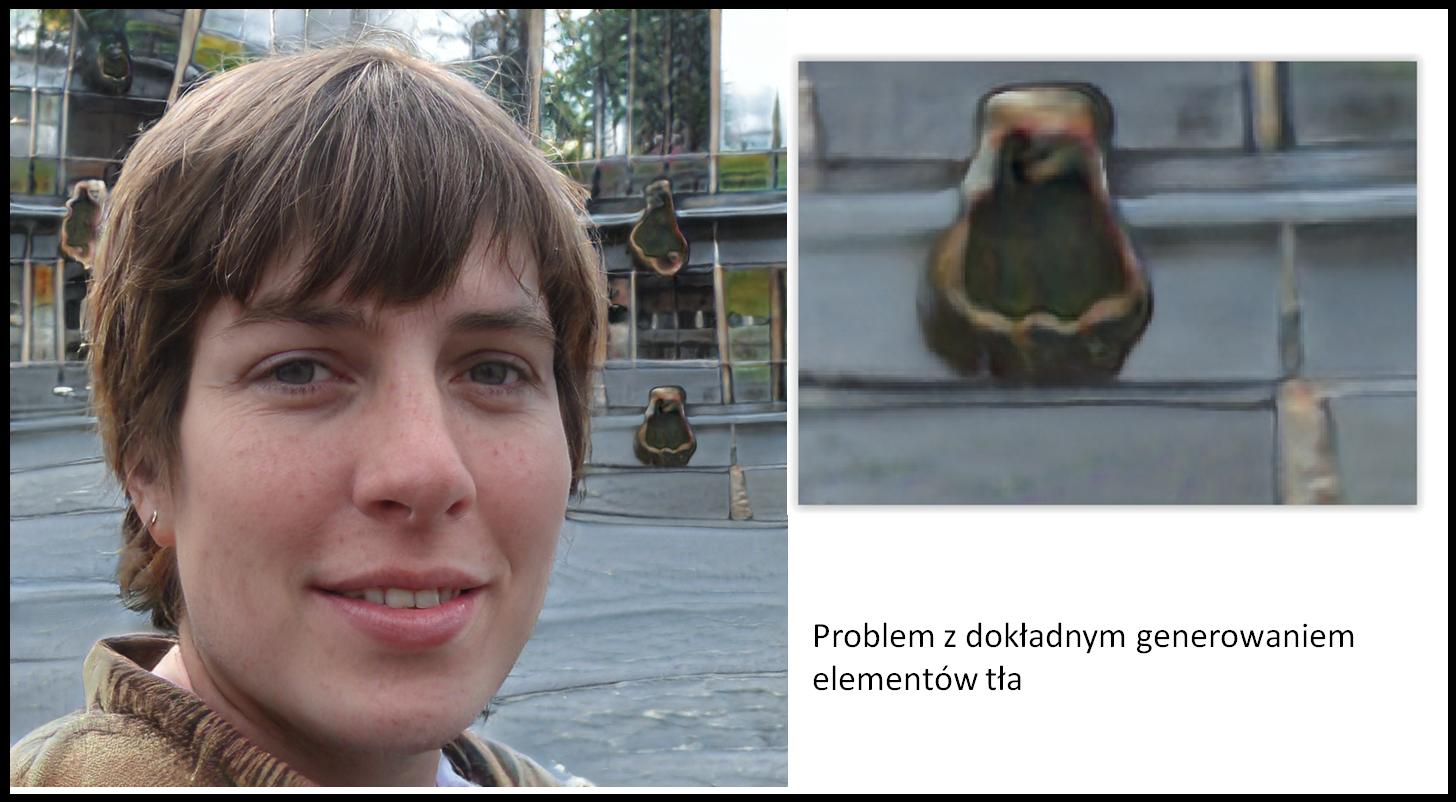

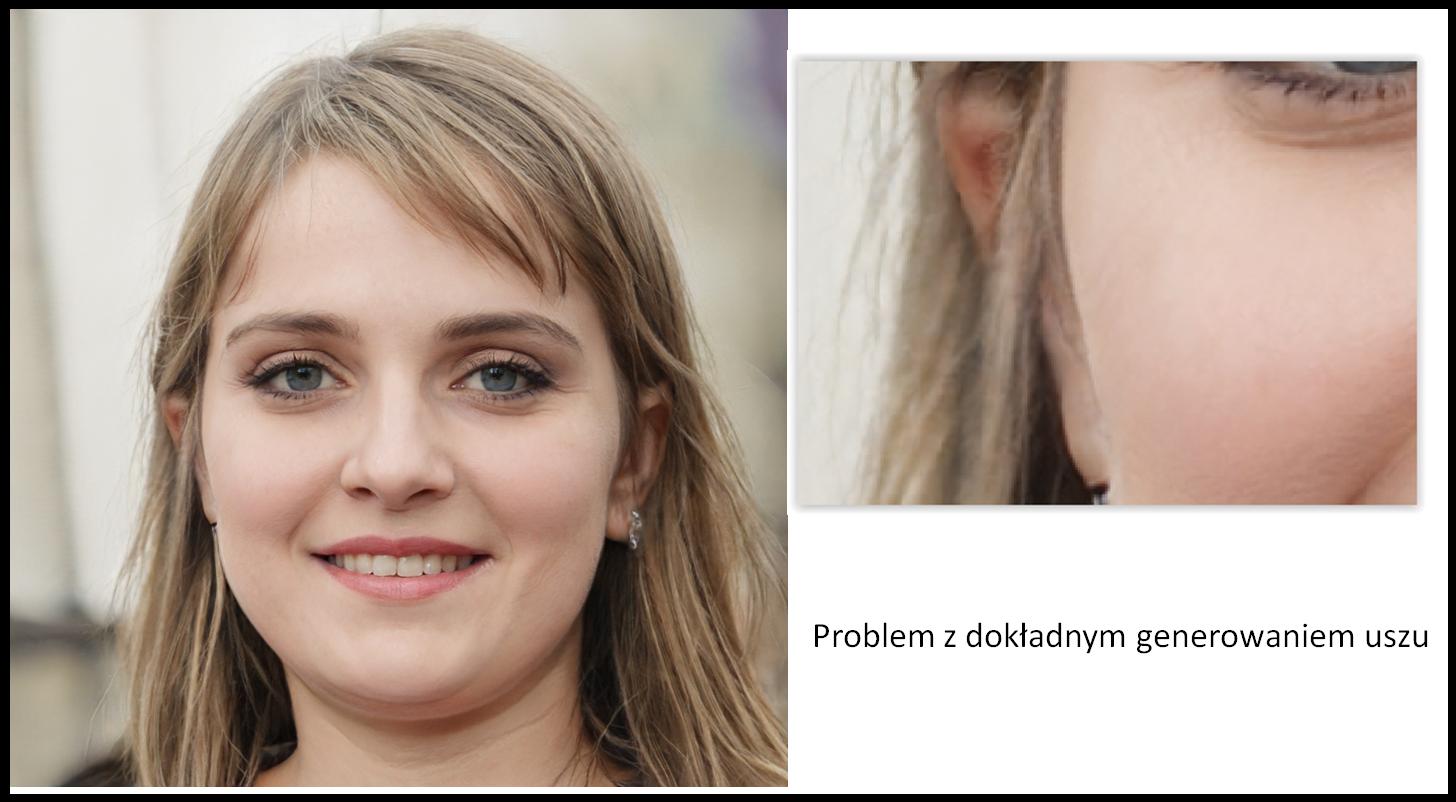

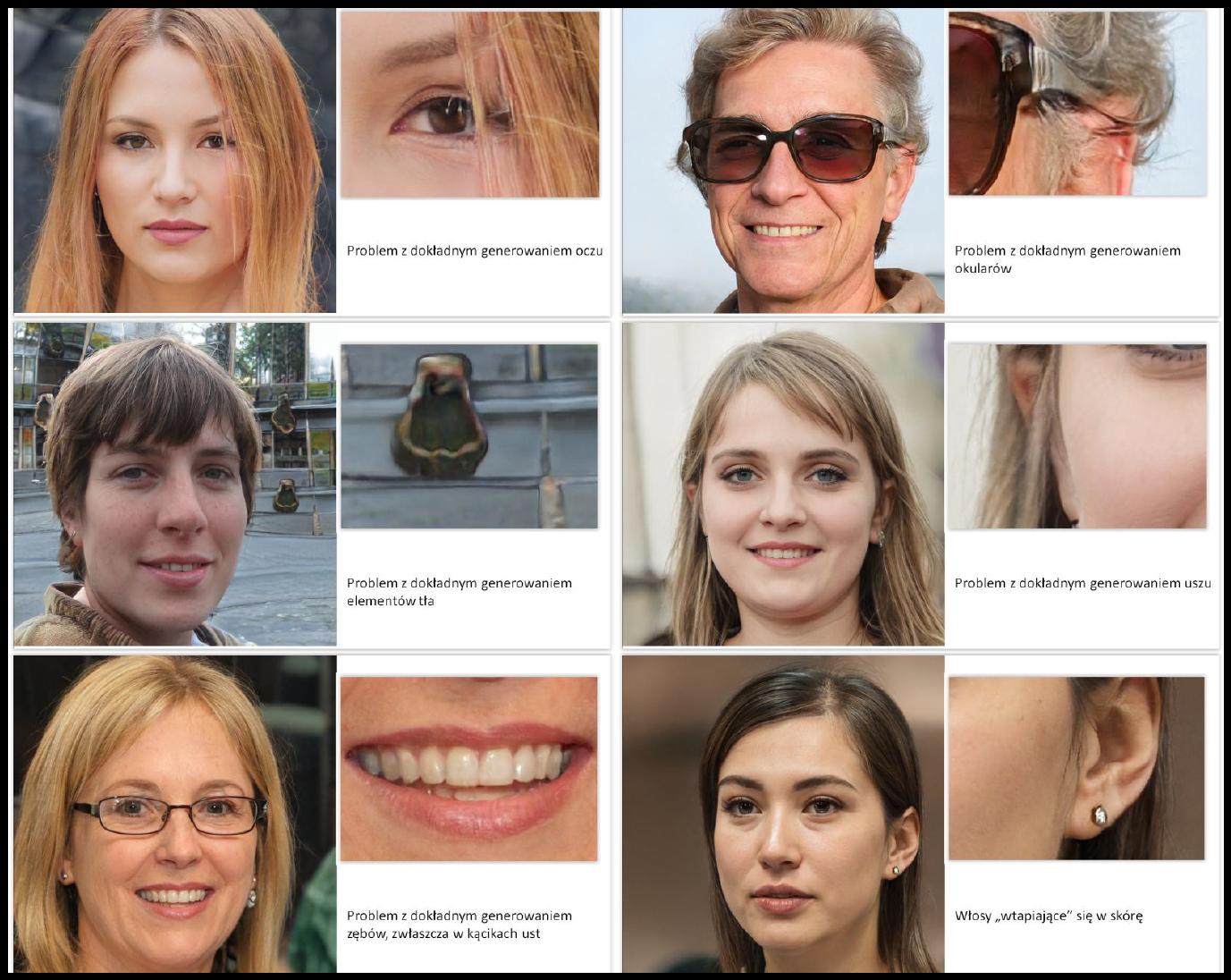

W projekcie planowany jest rozwój metod wykrywania materiałów deepfake, zarówno w postaci pojedynczych obrazów, jak i nagrań wideo. Wykorzystane w tym celu zostaną różne metody uczenia maszynowego, nie tylko sztuczne sieci neuronowe. Planowane jest również wykorzystanie algorytmów wykrywania anomalii, jak również wykorzystanie ewolucyjnych algorytmów w celu optymalizacji lokalnych deskryptorów obrazów, tak by opracowane w ten sposób deskryptory były bardziej skuteczne w wykrywaniu charakterystycznych błędów i niedociągnięć metod generowania materiałów deepfake.

Trwa wyścig zbrojeń

Naukowcy Politechniki Krakowskiej prognozują, że podobnie jak pomiędzy twórcami wirusów komputerowych oraz autorami programów antywirusowych trwa nieustający wyścig zbrojeń, tak podobna sytuacja będzie miała miejsca pomiędzy twórcami materiałów deepfake a badaczami SI, którzy będą się starali opracować jak najlepsze metody ich wykrywania. – Pojawienie się głośnych medialnie przypadków prób groźnego wykorzystania fałszywych materiałów w celu walki politycznej, zniesławienia bądź oszustwa czyni nasz projekt jeszcze bardziej pożądanym rynkowo – uważa prof. Michał Bereta.

Prace nad projektem pt. „Detekcja zmanipulowanych treści audio-wideo w celu ochrony przed rozprzestrzenianiem wiadomości o charakterze deepfake” prowadzone są w ramach I konkursu „Infostrateg” Narodowego Centrum Badań i Rozwoju. Zespół naukowców z Politechniki Krakowskiej (dr hab. inż. Michał Bereta, prof. PK, dr inż. Paweł Jarosz, dr Adam Marszałek, wspierani przez dr. hab. Pawła Karczmarka, prof. Politechniki Lubelskiej) otrzymał na nie dofinansowanie w wysokości blisko 4 mln zł. Głównym celem badań naukowych i prac rozwojowych w ramach programu „Infostrateg” jest rozwój polskiego potencjału SI poprzez opracowanie rozwiązań wykorzystujących sztuczną inteligencję i blockchain, a mających bezpośrednie zastosowanie w praktyce.

(mas)

Grafiki użyte w tekście przedstawiają wygenerowane sztucznie zdjęcia nieistniejących ludzi z podpowiedzią dla wykrywaczy treści typu deepfake